Дебати на тему штучного інтелекту та його небезпеки/користу для суспільства почалися дуже давно. Про ІІ та його вплив на навколишній світ написано багато фантастичних книг та науково-популярних статей, знято безліч фільмів, час від часу про це йдеться у блогах та соцмережах. Сьогодні ми пропонуємо до вашої уваги адаптований переклад

статті Жоао Дуарте (João Duarte), в якій він ділиться своєю думкою на цю тему.

На початку листопада 2017 року я приїхав на «Всесвітній симпозіум: Штучний Інтелект та Інклюзія», в якому взяли участь понад 200 людей з усього світу. Особисто мене цікавило два питання: (1) як створювати ІІ-рішення, які могли б враховувати суспільні культурні цінності та (2) як використовувати ІІ в освіті. У статті я хочу поділитися п'ятьма думками, які я виніс для себе за підсумками цього заходу.

1. ІІ може завдати шкоди (навіть якщо його призначення полягає зовсім в іншому)

Розвиток ІІ приносить реальну користь у таких галузях як освіта, медицина, медіа, управління тощо. Але в той же час, його використання може завдавати шкоди та дискримінації.

Девіантна поведінка ІІ може бути викликана низкою причин:

- використання упереджених, необ'єктивних чи неякісних даних під час навчання;

- неправильно сформульовані правила;

- використання поза контекстом;

- створення циклів зворотний зв'язок.

| Девіантна поведінка (також соціальна девіація, поведінка, що відхиляється) — це стійка поведінка особистості, що відхиляється від загальноприйнятих, найбільш поширених і усталених суспільних норм |

Solid Bomb Gold була компанією з виробництва футболок, яка використовувала ІІ при генеруванні фраз для друку на своїй продукції. Одна з фраз, яку створив алгоритм, звучала так "

Keep Calm and Rape a Lot " (Зберігайте спокій і ґвалтуйте більше). І ось така, начебто, незначна помилка ІІ коштувала компанії всього. Цей випадок був широко висвітлений у ЗМІ та отримав відповідні відгуки. Після такого скандалу майданчик Amazon відмовив Solid Bomb Gold у співпраці, і компанія припинила своє існування.

Насправді алгоритм, звичайно, не передбачав створення такого образливого контенту. Він діяв просто: вибирав будь-яке дієслово зі списку, і одного разу потрапив саме на слово «ґвалтувати». Це — чудовий приклад неякісних даних та погано визначених правил.

Nikon додав у свої фотоапарати функцію, яка попереджала фотографа, про те, що хтось моргнув. Але через деякий час з'явабося відгуки користувачів про неправильне реагування функції зйомки людей з монголоїдним типом зовнішності. І хоча Nikon – японська компанія, схоже, у своїх алгоритмах вона не врахувала особливості будови очей мешканців азіатського регіону.

Пам'ятаєте фільм

«Особлива думка» з Томом Крузом? У картині машини пророкували, де і коли має статися злочин, і поліція могла його попередити. Щось подібне відбувається зараз.

Компанія

PredPol використовує ІІ для передбачення злочинів з метою допомогти поліції оптимізувати патрульні ресурси. Дані, які використовувала компанія для навчання моделі, були взяті зі звітів щодо злочинів, зафіксованих поліцією. Але далеко не всі порушення можуть бути відстежені та запротокольовані. Злочини реєструвалися найчастіше у районах, де найбільше патрулів. Цей факт може зациклити програму, яка направляє патрульну службу в райони, що вже патрулюються. Тут знову було використання необ'єктивних даних, а також петля зворотного зв'язку. Отже, навіть якщо призначення ІІ полягає зовсім в іншому, існує ймовірність, що він може завдати шкоди.

2. ІІ може навчитися бути справедливим (іноді набагато краще, ніж люди)

Не так легко визначити, що справедливо, а що — ні. Це питання слід розглядати індивідуально, враховуючи закон, культурні аспекти, оцінку цінностей та різні (обґрунтовані) точки зору. Однак якщо з усієї множини випадків виділити однозначне «добро» або «зло», штучний інтелект може навчатися на таких прикладах. ІІ працює, вивчаючи, як використовувати змінні для отримання цільового результату (об'єктивних функцій). І ми можемо покращити справедливість ІІ, використовуючи такі оціночні дані як об'єктивні функції, або як обмеження змінних. Якщо ми навмисно вирішуємо навчити ІІ концепції справедливості, потрібно враховувати, що система використовуватиме її буквальніше, ніж люди. Тому що ІІ куди ефективніше, ніж ми, дотримується правил. Це демонструють численні приклади. Так, бразильська компанія

Desabafo Social провела кампанію, що демонструє приклади дискримінації в системах пошуку зображень

Shutterstock та

Google . Один із результатів — якщо ви відправите запит «малюк» до Shutterstock, то швидше за все на більшості фотографій будуть білі малюки (

а якщо в Google, то першим буде кліп Джастіна Бібера Baby, прим. ред. ).

Пошукова система не відбиває реальний стан справ на Землі, але її можна цьому навчити. Якщо поставити як одну з цілей «відбивати різноманітність людства», ІІ може використати величезний обсяг даних, щоб гарантувати таке уявлення ґрунтуючись на расових, гендерних та культурних аспектах. У таких питаннях машини ефективніші за людей. У розглянутому прикладі результат роботи ІІ дискримінаційний, оскільки його так навчабо. Але ми завжди можемо придумати ефективніші алгоритми, щоб уникнути цього.

3. ІІ змушує нас переглянути етичні та моральні принципи

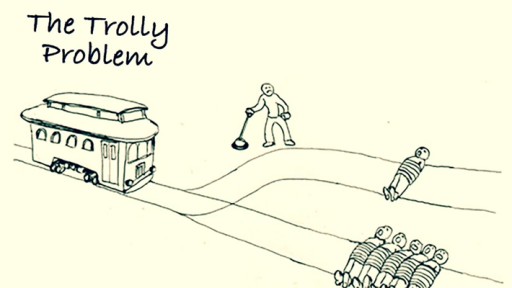

Як ми бачабо раніше, ІІ намагається оптимізувати змінні задля досягнення конкретної мети. У процесі роздумів про ці цілі постійно виникають етичні та моральні питання, які були на слуху якийсь час тому, а тепер знову набули актуальності. Але є й нові питання, чия поява спровокувала можливості ІІ. На першому занятті курсу юстиції в Гарварді філософ

Майкл Сандель (Michael Sandel) розглядає моральну дилему під назвою "

Проблема вагонетки " (Trolley problem), яка була вперше піднята у 1905 році. Це завдання моделює типову моральну дилему — чи можна зашкодити одному чи декільком людям заради врятування життя інших людей.

Отже, ситуація: важка некерована вагонетка мчить по рейках. На шляху її прямування перебувають п'ятеро людей, прив'язані до рейок. На щастя, ви можете переключити стрілку — і тоді вагонетка поїде по іншому, запасному шляху. На жаль, на запасному шляху знаходиться одна людина, також прив'язана до рейок. Які ваші дії? Якщо ви нічого не зробите, вагонетка уб'є п'ять чоловік. Якщо ж перемкнете стрілку, вона вб'є тільки одного. З такою проблемою стикаються інженери автономних транспортних засобів, яким необхідно вирішити, чи слід встановлювати пріоритети щодо життя людей усередині або поза транспортним засобом.

4. Немає поняття «нейтральності ІІ»

Використання ІІ впливає на наше життя та змінює його. Наприклад, ми використовуємо

Google Maps для пошуку найкоротшого шляху і нам більше не потрібно питати людей на вулиці. Так ми менше спілкуємося з людьми у незнайомому місці або іншому місті під час мандрівок. Або ж розглянемо взаємодію дітей із віртуальними помічниками

Siri та

Alexa . Це палиця з двома кінцями. З одного боку, діти стають більш цікавими, тому що можуть запитати будь-що в будь-який час доби. З іншого боку, батьки зазначають, що діти стають менш ввічливими.

Ілюстрація Бі Джонсон (Bee Johnson) для Washington Post

Адже в них відпадає необхідність використовувати слова «будь ласка» та «дякую». І це змінює те, як діти вчаться взаємодіяти зі світом

|

«Алгоритми не є нейтральними. Якщо змінимо алгоритм, ми змінимо реальність»

- Desabafo Social |

Проте інженери штучного інтелекту можуть змінити це, запрограмувавши помічників так, щоб при грубому поводженні вони відповідали щось на кшталт: «Гей, треба використовувати чарівне слово». Ми маємо можливість створювати наміри в рамках ІІ і таким чином відстоювати певну точку зору. Отже, хоча ІІ може бути нейтральним, може бути інструментом формування бажаного поведінки у суспільстві. І замість того, щоб прагнути нейтралітету, ми повинні прагнути доцільності.

5. ІІ потребує різноманітності для забезпечення успіху

Алгоритми штучного інтелекту

завжди відповідатимуть точці зору своїх творців. Напрошується висновок, що найкращий спосіб забезпечити успіх ІІ — сприяти різноманітності у цій галузі. ІІ-інженерами повинні ставати люди різних національностей, чоловіки та жінки, з різними расовими та культурними аспектами. У такому разі вдасться забезпечити необхідну різноманітність. Щоб це сталося, необхідно збільшити доступ до освіти в області ІІ та гарантувати доступ до цих знань різним групам людей.

Кейтлін Сіміню (Kathleen Siminyu), спеціаліст з аналізу даних з Кенії, організувала в Найробі відділення організації

«Жінка в машинному навчанні та аналізі даних»(Woman in Machine Learning and Data Science, WiMLDS). Цей проект відіграє життєво важливу роль у збільшенні такого розмаїття серед ІІ-інженерів.

Сподіваюся, що ця стаття виявиться корисною і зможе вам стати в нагоді. Я вважаю, що розуміння питань етики під час створення ІІ — це перший крок до створення більш справедливого та інклюзивного штучного інтелекту.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви думаєте.]() На початку листопада 2017 року я приїхав на «Всесвітній симпозіум: Штучний Інтелект та Інклюзія», в якому взяли участь понад 200 людей з усього світу. Особисто мене цікавило два питання: (1) як створювати ІІ-рішення, які могли б враховувати суспільні культурні цінності та (2) як використовувати ІІ в освіті. У статті я хочу поділитися п'ятьма думками, які я виніс для себе за підсумками цього заходу.

На початку листопада 2017 року я приїхав на «Всесвітній симпозіум: Штучний Інтелект та Інклюзія», в якому взяли участь понад 200 людей з усього світу. Особисто мене цікавило два питання: (1) як створювати ІІ-рішення, які могли б враховувати суспільні культурні цінності та (2) як використовувати ІІ в освіті. У статті я хочу поділитися п'ятьма думками, які я виніс для себе за підсумками цього заходу.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви думаєте.]() Насправді алгоритм, звичайно, не передбачав створення такого образливого контенту. Він діяв просто: вибирав будь-яке дієслово зі списку, і одного разу потрапив саме на слово «ґвалтувати». Це — чудовий приклад неякісних даних та погано визначених правил. Nikon додав у свої фотоапарати функцію, яка попереджала фотографа, про те, що хтось моргнув. Але через деякий час з'явабося відгуки користувачів про неправильне реагування функції зйомки людей з монголоїдним типом зовнішності. І хоча Nikon – японська компанія, схоже, у своїх алгоритмах вона не врахувала особливості будови очей мешканців азіатського регіону.

Насправді алгоритм, звичайно, не передбачав створення такого образливого контенту. Він діяв просто: вибирав будь-яке дієслово зі списку, і одного разу потрапив саме на слово «ґвалтувати». Це — чудовий приклад неякісних даних та погано визначених правил. Nikon додав у свої фотоапарати функцію, яка попереджала фотографа, про те, що хтось моргнув. Але через деякий час з'явабося відгуки користувачів про неправильне реагування функції зйомки людей з монголоїдним типом зовнішності. І хоча Nikon – японська компанія, схоже, у своїх алгоритмах вона не врахувала особливості будови очей мешканців азіатського регіону.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви вважаєте - 3]() Пам'ятаєте фільм «Особлива думка» з Томом Крузом? У картині машини пророкували, де і коли має статися злочин, і поліція могла його попередити. Щось подібне відбувається зараз.

Пам'ятаєте фільм «Особлива думка» з Томом Крузом? У картині машини пророкували, де і коли має статися злочин, і поліція могла його попередити. Щось подібне відбувається зараз.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви вважаєте - 4]() Компанія PredPol використовує ІІ для передбачення злочинів з метою допомогти поліції оптимізувати патрульні ресурси. Дані, які використовувала компанія для навчання моделі, були взяті зі звітів щодо злочинів, зафіксованих поліцією. Але далеко не всі порушення можуть бути відстежені та запротокольовані. Злочини реєструвалися найчастіше у районах, де найбільше патрулів. Цей факт може зациклити програму, яка направляє патрульну службу в райони, що вже патрулюються. Тут знову було використання необ'єктивних даних, а також петля зворотного зв'язку. Отже, навіть якщо призначення ІІ полягає зовсім в іншому, існує ймовірність, що він може завдати шкоди.

Компанія PredPol використовує ІІ для передбачення злочинів з метою допомогти поліції оптимізувати патрульні ресурси. Дані, які використовувала компанія для навчання моделі, були взяті зі звітів щодо злочинів, зафіксованих поліцією. Але далеко не всі порушення можуть бути відстежені та запротокольовані. Злочини реєструвалися найчастіше у районах, де найбільше патрулів. Цей факт може зациклити програму, яка направляє патрульну службу в райони, що вже патрулюються. Тут знову було використання необ'єктивних даних, а також петля зворотного зв'язку. Отже, навіть якщо призначення ІІ полягає зовсім в іншому, існує ймовірність, що він може завдати шкоди.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви вважаєте - 5]() Пошукова система не відбиває реальний стан справ на Землі, але її можна цьому навчити. Якщо поставити як одну з цілей «відбивати різноманітність людства», ІІ може використати величезний обсяг даних, щоб гарантувати таке уявлення ґрунтуючись на расових, гендерних та культурних аспектах. У таких питаннях машини ефективніші за людей. У розглянутому прикладі результат роботи ІІ дискримінаційний, оскільки його так навчабо. Але ми завжди можемо придумати ефективніші алгоритми, щоб уникнути цього.

Пошукова система не відбиває реальний стан справ на Землі, але її можна цьому навчити. Якщо поставити як одну з цілей «відбивати різноманітність людства», ІІ може використати величезний обсяг даних, щоб гарантувати таке уявлення ґрунтуючись на расових, гендерних та культурних аспектах. У таких питаннях машини ефективніші за людей. У розглянутому прикладі результат роботи ІІ дискримінаційний, оскільки його так навчабо. Але ми завжди можемо придумати ефективніші алгоритми, щоб уникнути цього.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви думаєте.]() Отже, ситуація: важка некерована вагонетка мчить по рейках. На шляху її прямування перебувають п'ятеро людей, прив'язані до рейок. На щастя, ви можете переключити стрілку — і тоді вагонетка поїде по іншому, запасному шляху. На жаль, на запасному шляху знаходиться одна людина, також прив'язана до рейок. Які ваші дії? Якщо ви нічого не зробите, вагонетка уб'є п'ять чоловік. Якщо ж перемкнете стрілку, вона вб'є тільки одного. З такою проблемою стикаються інженери автономних транспортних засобів, яким необхідно вирішити, чи слід встановлювати пріоритети щодо життя людей усередині або поза транспортним засобом.

Отже, ситуація: важка некерована вагонетка мчить по рейках. На шляху її прямування перебувають п'ятеро людей, прив'язані до рейок. На щастя, ви можете переключити стрілку — і тоді вагонетка поїде по іншому, запасному шляху. На жаль, на запасному шляху знаходиться одна людина, також прив'язана до рейок. Які ваші дії? Якщо ви нічого не зробите, вагонетка уб'є п'ять чоловік. Якщо ж перемкнете стрілку, вона вб'є тільки одного. З такою проблемою стикаються інженери автономних транспортних засобів, яким необхідно вирішити, чи слід встановлювати пріоритети щодо життя людей усередині або поза транспортним засобом.

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви думаєте.]()

![Штучний інтелект справді небезпечний. Але зовсім не так, як ви думаєте.]() Сподіваюся, що ця стаття виявиться корисною і зможе вам стати в нагоді. Я вважаю, що розуміння питань етики під час створення ІІ — це перший крок до створення більш справедливого та інклюзивного штучного інтелекту.

Сподіваюся, що ця стаття виявиться корисною і зможе вам стати в нагоді. Я вважаю, що розуміння питань етики під час створення ІІ — це перший крок до створення більш справедливого та інклюзивного штучного інтелекту.

ПЕРЕЙДІТЬ В ПОВНУ ВЕРСІЮ